Valutazione iniziale della sicurezza di un processo di machine learning.

Wibu-Systems, pioniere della sicurezza informatica, della protezione di beni digitali e della loro monetizzazione, si adopera attivamente per preservare l’intero insieme di tecnologie scaturite dall’Industria 4.0.

Nell’ultimo decennio, si è verificata una rivoluzione silenziosa in quasi tutti i settori della nostra vita: l'intelligenza artificiale e il machine learning si sono inesorabilmente affermati come parte integrante della nostra esperienza quotidiana. Dai complessi calcoli scientifici al riconoscimento automatico delle immagini o anche ai chatbot, apparentemente semplici, ma anche ingannevolmente realistici nei negozi online o negli helpdesk, gli algoritmi di apprendimento automatico stanno dando ai dispositivi, con cui abbiamo quotidianamente a che fare, un nuovo tipo di intelligenza. Di fronte a questa nuova realtà, dobbiamo chiederci: Possiamo fidarci delle macchine? E ancor più, possiamo fidarci del fatto che le macchine stiano imparando ciò che pensiamo e faranno ciò che ci aspettiamo da loro?

Da quando i ricercatori sono stati in grado di dimostrare che semplici manipolazioni possono ingannare anche i sistemi di IA più intelligenti, la comunità ha dibattuto a lungo sull'affidabilità del machine learning. Un vero momento spartiacque è arrivato, quando il ricercatore di Google Christian Szegedy e il suo team hanno dimostrato nel 2014 che una forma leggermente più raffinata di sabotaggio potrebbe bloccare i sistemi di riconoscimento delle immagini. Queste potrebbero essere "avvelenate" con alterazioni minori, quasi impercettibili all'occhio umano, che confonderebbero quasi sicuramente il sistema di riconoscimento, portando, ad esempio, a scambiare un animale per un veicolo a motore.

Il pericolo di sabotaggio ai sistemi di apprendimento automatico è diventato un problema tangibile, che va, tuttavia, affrontato alla radice.

ALZARE LA POSTA IN GIOCO

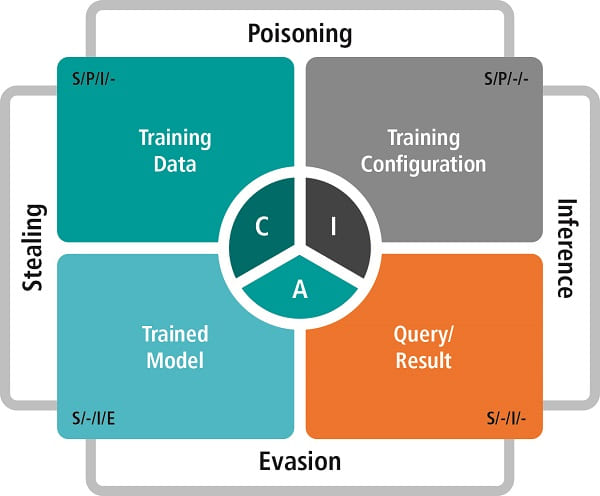

Il pericolo di sabotaggio ai sistemi di apprendimento automatico è diventato un problema tangibile, che va, tuttavia, affrontato alla radice. Il machine learning è un processo, non un prodotto fatto e finito. Molti degli attacchi dimostrati in passato erano rivolti all'output, cioè al sistema adulto, completamente addestrato, che potrebbe essere mandato in confusione, ad esempio, con una manomissione intelligente delle immagini che dovrebbe riconoscere. Ciononostante, il rischio è presente durante tutta la vita del sistema, dalla sua nascita, attraverso il suo apprendimento, fino alla maturità operativa.

In sostanza, nel machine learning, e specialmente nella sua forma più popolare, il deep learning, invece di insegnare alla macchina ad effettuare un ipotetico lavoro, con una sequenza predefinita di istruzioni, viene dato un insieme di parametri per aiutarla a riconoscere modelli all’interno dell’assieme di dati. Potrebbero essere immagini di volti umani, frammenti di comandi vocali, o video di oggetti in movimento, che il sistema si trova a dover riconoscere o a cui deve rispondere in un certo modo. Questo addestramento avviene ripetutamente, fino a quando la macchina non dimostra di reagire come previsto.

I rischi non si limitano al modello finito, che potrebbe essere ingannato o sottratto illecitamente da un concorrente, che volesse saltare il laborioso e costoso processo di formazione del modello. Gli attacchi potrebbero prendere di mira anche l’assieme iniziale dei dati o il processo di formazione stesso, per un effetto più insidioso. Quando il sistema venisse istruito con esempi corrotti, il modello finale sarebbe similmente corrotto. Un modello di ML medico, che fosse stato alimentato, con scansioni radiografiche riportanti piccole modifiche, potrebbe crescere fino a diventare un sistema diagnostico IA, che sembra funzionare bene all’apparenza (ma determina errori di diagnosi o mostra una qualità leggermente inferiore), al fine di favorire un sistema concorrente agli occhi dell’ufficio acquisti della struttura sanitaria.

Analogamente, il processo di addestramento potrebbe subire attacchi informatici, perché molti di questi sistemi vedono l’intervento di terze parti o risiedono su cloud. Queste condizioni potrebbero lasciarli vulnerabili a spionaggio, furto o, nuovamente, sabotaggio. Non tutti gli attacchi devono necessariamente essere sferrati su larga scala. I sistemi di IA addestrati per compiti di cybersicurezza potrebbero, per esempio, essere manipolati per mancare solo un singolo tipo di attacco o intrusione, dando al sabotatore una backdoor, che è inserita nel sistema proprio fin dalla sua infanzia virtuale.

Wibu-Systems mette in sicurezza l’intero insieme di tecnologie scaturite dall’Industria 4.0.

PROSPETTIVE ROSEE PER IL FUTURO

Anche se molte di queste manipolazioni sono state finora dimostrate solo a livello teorico, il problema richiede maggiore attenzione e soluzioni pratiche, che vadano da quelle apparentemente banali, come la scelta accurata dell'operatore cloud, su cui viene ospitato l'ambiente di apprendimento, a metodi per preservare l'integrità dei dati di formazione per mezzo di trusted elements, tecnologie di autenticazione e rilevamento delle anomalie.

Con l'IA e il machine learning attivi in aree che influenzano direttamente la vita e i mezzi di sostentamento umani, gli specialisti in cybersicurezza hanno riconosciuto che l'affidabilità è una questione ancora più pressante di quanto non lo sia già nei loro dominii abituali – nel software convenzionale o nella protezione dei dati. Questo espande il campo di battaglia, in un ambito già sotto la minaccia incombente del quantum computing.

A partire da elementi hardware sicuri, strumenti crittografici all’avanguardia e un sistema olistico per la gestione, la distribuzione e l’amministrazione dei diritti utente, Wibu-Systems darà il proprio apporto per mantenere i processi di machine learning degni di fiducia.

I cyber attacchi possono prendere di mira anche l’assieme iniziale dei dati per un effetto più insidioso.

PARTNER PER LA SICUREZZA

Da oltre trent’anni, Wibu-Systems, pioniere della sicurezza informatica, della protezione di beni digitali e della loro monetizzazione, è impegnata sul fronte dell’innovazione. L’azienda collabora pertanto attivamente con poli accademici e un numero crescente di vendor internazionali, per mettere in sicurezza l’intero insieme di tecnologie scaturite dai principi dell’Industria 4.0. Gli attuali progetti di ricerca che la vedono coinvolta spaziano dall’industria additiva, al post-quantum computing, dalle architetture SoC (Systems-on-a-Chip) ad un’elettronica sicura by design. Ne è un esempio VE-ASCOT, un progetto che è stato avviato per sviluppare una piattaforma dedicata di Chain of Trust per uno dei settori più sensibili dell'industria, la produzione di componenti per semiconduttori. Poiché questi ultimi sono onnipresenti nella vita moderna, la capacità di manomettere la loro produzione offrirebbe agli aggressori – siano essi concorrenti commerciali senza scrupoli, criminali o anche attori statali – un mezzo per colpire virtualmente qualsiasi aspetto della nostra esistenza economica, sociale e politica. Ogni elemento nella Chain of Trust rappresenta una porzione dell'identità del componente, da proteggere con metodi crittografici per garantirne unicità, integrità e autenticità durante l'intero ciclo di vita del prodotto in cui è inserito il componente stesso. All’uopo, vengono utilizzati non solo repository a prova di manomissione, ma anche nuovi marcatori di identità, come le "chiavi fisiche offuscate", dati di sensori od altre caratteristiche tecniche che permetteranno di identificare univocamente ogni modulo elettronico. La catena di fiducia proposta dal progetto SiEvEI 4.0 si basa invece sullo sviluppo di SSI, Smart Security Items, e sulla tecnologia dei sensori per stabilire, mediante edge computing, la comunicazione con il sistema di archiviazione dei certificati. Sebbene, molti degli obiettivi preposti siano in primis legati al mondo manifatturiero, non mancano anche finalità in ambito specificamente medico. È il caso di PQC4MED, che si rivolge al mondo dei dispositivi medicali interconnessi, per i quali intende sviluppare e incorporare elementi sicuri con firmware aggiornabile e creare un'infrastruttura di backend dotata di strumenti di protezione PCQ-ready, per la gestione delle licenze, delle chiavi crittografiche e delle risorse di sistema. ©ÈUREKA!

Ciclo di vita, risorse e attori coinvolti nei processi di machine learning.